发布日期:2025-04-17 09:17 点击次数:109

Key Points

从快猜想慢想:筹办范式变了,芯片的架构也需要改动;

黄仁勋给出了每两年更换一代架构的芯片战术,但他更首要的战术是对于AI的;

AMD争夺终局,英伟达押注云表;

AI芯片自身的护城河其实莫得那么深,尤其推理芯片。

「一个Hopper芯片不错为每个用户每秒产生轻便100个token,一个兆瓦级数据中心每秒不错产生10万个token。」黄仁勋说,如果进行超等批量处理,那么一个AI工场每秒不错产生的token量不错达到轻便250万个。

「ChatGPT的成本轻便是每百万个token 10好意思元,250万乘以10,那等于每秒25万好意思元。」他陆续说,一年青便有3000万秒,乘起来等于上万亿,「这等于兆瓦级数据中心的营收,这等于您的方针。」

当地时候3月18日,黄仁勋在由英伟达举办的年度GTC(GPU Technology Conference)大会上进行了一场长达两个半小时的演讲。和此前历次在GTC、台北Computex电脑节以及不久前举办的CES大会上的发言不同,黄仁勋在这次GTC大会上作念的最多的事情之一等于算账。

黄仁勋说,DeepSeek火了之后,4大云厂商反而买了更多英伟达芯片,而不是更少。

本年1月底DeepSeek大火之后,由于检会和推理成本的数目级式下降,商场有声息合计商场不再需要那么多英伟达芯片了,英伟达股价因此从153好意思元/股的高点一皆下降到104好意思元/股。粗略出于试图扭转商场对英伟达翌日主见的启事,3月18日的演讲中,黄仁勋铆足了劲构建和倾销他的「token经济学」。

「昨年,简直全寰球都错了。」他断言说,「AI的筹办需求事实上是加快的,其畛域化定律(scaling law)具有刚劲韧性。」

凭据他的算法,「模子推理需要的算力破钞比咱们当下以为的还要多100倍。」

英伟达依然是目下环球最大的AI芯片公司。凭据Jon Peddie Research数据,戒指2024年三季度,英伟达在环球AI芯片商场份额高达90%;与此同期,以AI芯片为主的数据中心业务亦然英伟达营收和利润的最大孝顺者,占比高达88%。

这家公司还能怎么增长?黄仁勋的每次公开演讲都在恢复这个问题,这次也不例外,但外界买不买账是另外一趟事。

从快猜想慢想:筹办范式变了,芯片的架构也需要改动

发布会一启动,黄仁勋就点出了昨年DeepSeek推出后业界对于「AI筹办需求行将断崖式下滑」的判断不仅是错的,而且错得离谱。他给出的事理不是杰文斯悖论中提到的「成果栽植反而令资源破钞激增」,而是筹办范式的调治自身带来的——大模子正在从GPT那样的直观式「快想考」模式,转向OpenAI o1和DeepSeek R1这么通过构建冉冉推导的想维链进行推理的「慢想」模式。

黄仁勋合计,模子想考范式的切换,会同期为模子检会和推理商场带来筹办量上的大幅增长。当先,当大模子公司们坚定到将「预检会」好的基础模子(比如GPT)再使用强化学习环节进行「后检会」之后,就能得到具有多步想考才略的推理模子,模子检会的需求就会再次取得一拨算力增长;其次,也更首要的是,推理模子的多步以致反想历程,会比径直给出谜底破钞更多token——黄仁勋瞻望这种慢想破钞的token量轻便是快想模式的10倍。

「为了保持模子的反映速率和交互性,幸免用户因恭候其想考而失去耐性,咱们当今还需要筹办速率提高10倍。」黄仁勋说,如斯一来,token破钞量增多10倍,筹办速率也栽植10倍,共筹办量「简略地就能达到百倍」。

黄仁勋说,数据中心AI商场会成长到1万亿好意思元的畛域。

黄仁勋称,英伟达在往时每一个新筹办期间到来的拐点时刻都实时推出了稳当商场需求的芯片。2022年ChatGPT大火之年,英伟达推出了AI芯片的第一个系列Hopper系列,2024年,o1推理模子出生之前,英伟达也推出了新的Blackwell系列。相较于Hopper架构,Blackwell系列芯片的架构更稳当「推理」——它新增了对FP4(4位浮点运算,数字越高,筹办精度越高)数据体式的复旧,同期加大了内存。

以2024年3月推出的B200(Blackwell系列的第一款芯片)为例,它首度复旧FP4精度的筹办。低精度筹办对于目下游行的MoE(混杂群众模子)架构是必要的,故意于镌汰检会和推理的成本与成果。DeepSeek的R1模子等于一种MoE架构,况且接受以FP8为主的低筹办精度检会和推理。因为推理时只需要调用通盘模子中的极少「群众」,而无须动用通盘模子的所有参数,且只需要进行8位浮点运算,不像此前主流模子那样动辄需要筹办到FP16或FP32的精度,DeepSeek R1能以轻便唯有OpenAI o1模子3%的价钱提供推理就业。

GPU中内存的大小对非推理模子影响不大,但对推理模子至关首要。推理模子的多步推理意味着更大缓存,如果缓存过多,模子推理速率就会下降,这给用户酿成的径直体验等于,模子要花很长一段时候才能想好怎么恢复问题,而用户耐性是有限的。为了管理缓存爆炸问题,DeepSeek曾找到一种对缓存数据进行聚会压缩的环节,从而大大减少推理期间的内存使用。收成于这一革命,DeepSeek的第二代基础模子V2的生成微辞量达到了上一代模子(V1)最大生成微辞量的5.76倍。

虽然,DeepSeek的一系列模子是使用英伟达的最低阶AI芯片A100检会的,其内存和带宽都有限(A100内存唯有40GB,带宽最高2.5TB/s ),缓存压缩是莫得方针的方针。2024年推出第一代Blackwell系列芯片B200时,英伟达新增了对FP4筹办精度的复旧,还将内存空间增多到了192GB,径直通过升级硬件管理这一问题。

3月18日的GTC大会上,英伟达进一步发布了B200芯片的升级版B300,内存从B200的192GB进一步增多到288GB,同期,其FP4筹办性能也比B200提高了50%。

相较于Hopper系列芯片,Blackwell系列芯片为推理产生的缓存提供了更大内存和带宽。

在B300之后,黄仁勋公布了英伟达在AI芯片标的的通盘门道图。门道图显现,在2022年和2023年推出的基于Hopper架构的系列芯片、2024年和2025年推出基于Blackwell架构系列芯片之后,英伟达还将在2026年和2027年发布Rubin新架构和系列AI芯片,再之后是Feynman架构及相应芯片。Rubin和Feynman分手以天体裁家Vera Rubin和表面物理学家Richard Feynman(费曼)的名字定名。

这意味着,英伟达将每两年更新一代芯片架构。这种更新早就不再单纯为了算力,比如从第一代Hopper芯片到第二代Blackwell芯片,芯片加工接受的都是4nm工艺,尽管晶体管数目有增多,但芯片的性能增长越来越多来自架构的合感性而非算力自身的堆叠。以H100和B200为例,单片H100上有800亿个晶体管,B200增多到2080亿个,只增多了1.6倍。但性能上,B200的筹办性能差未几是H100的5倍——这种成果更多来自于对不休进化的算法的适配。

「芯片要管理的不光是筹办问题,如故I/O(开或关,即与资源分拨、通讯关联的问题)问题。」CUDA之父巴克(Ian Buck)曾示意。以越来越多被使用的MoE混杂群众模子为例,这种架构将模子剖析成一群擅长不同任务的群众,谁擅长什么,就将相应检会和推理任务分拨给谁。如斯一来,不同群众间的并行筹办和通讯就变得首要。为了找出肖似GPT-4这么的MoE模子检会时最合适的并行确立,英伟达曾进行过大批施行,以探索构建硬件和切割模子的正确组合。

AMD争夺终局,英伟达押注云表

从Blackwell架构启动,英伟达的芯片业务就越来越偏向于云表AI筹办了。这种倾向一方面体当今英伟达对于自家芯片适配模子算法迭代的实时性追求上:2024年3月发布Blackwell系列的第一款芯片B200时,推理模子尚未问世,OpenAI直到当年9月才推出其首款推理模子o1。B300的发布意味着英伟达只花了几个月时候,就准备好了一款更好适配新类型模子的芯片。如果凭据好意思国半导体商讨机构SemiAnalysis的报谈,炒股平台B300行将推出的讯息早在昨年12月就出现了,意味着市面上首款推理模子o1出现3个月后,英伟达的适配芯片就差未几就绪。

另一方面,英伟达对于云表AI芯片的侧重也体当今其对云表即数据中心业务的深爱进度上。不论是Hopper如故Blackwell,以及之后的Rubin和Feynman,这一系列芯片都是为数据中心准备的,唯有那边的就业器才能运行如斯算力畛域的芯片,用以模子检会或者云表推理。

数据中心业务成为英伟达最大的获利机器。

而与此同期,AMD正花鼎力气想要霸占的,是每个东谈主不错拿在手里、放在家里桌面的袖珍开荒里的终局AI芯片。就在英伟达GTC大会召开的前一天,AMD在北京召开了「AMD AI PC」为主题的革命峰会,AMD董事会主席兼CEO苏姿丰躬行站台,膨胀公司旗下多个AIPC处理器,包括锐龙AI Max系列、锐龙AI 300系列、锐龙9000HX系列等,晓示搭载这些新品的AIPC将很快面世。守望、华硕、微软、宏碁等PC厂商都参加了AMD的这次峰会。

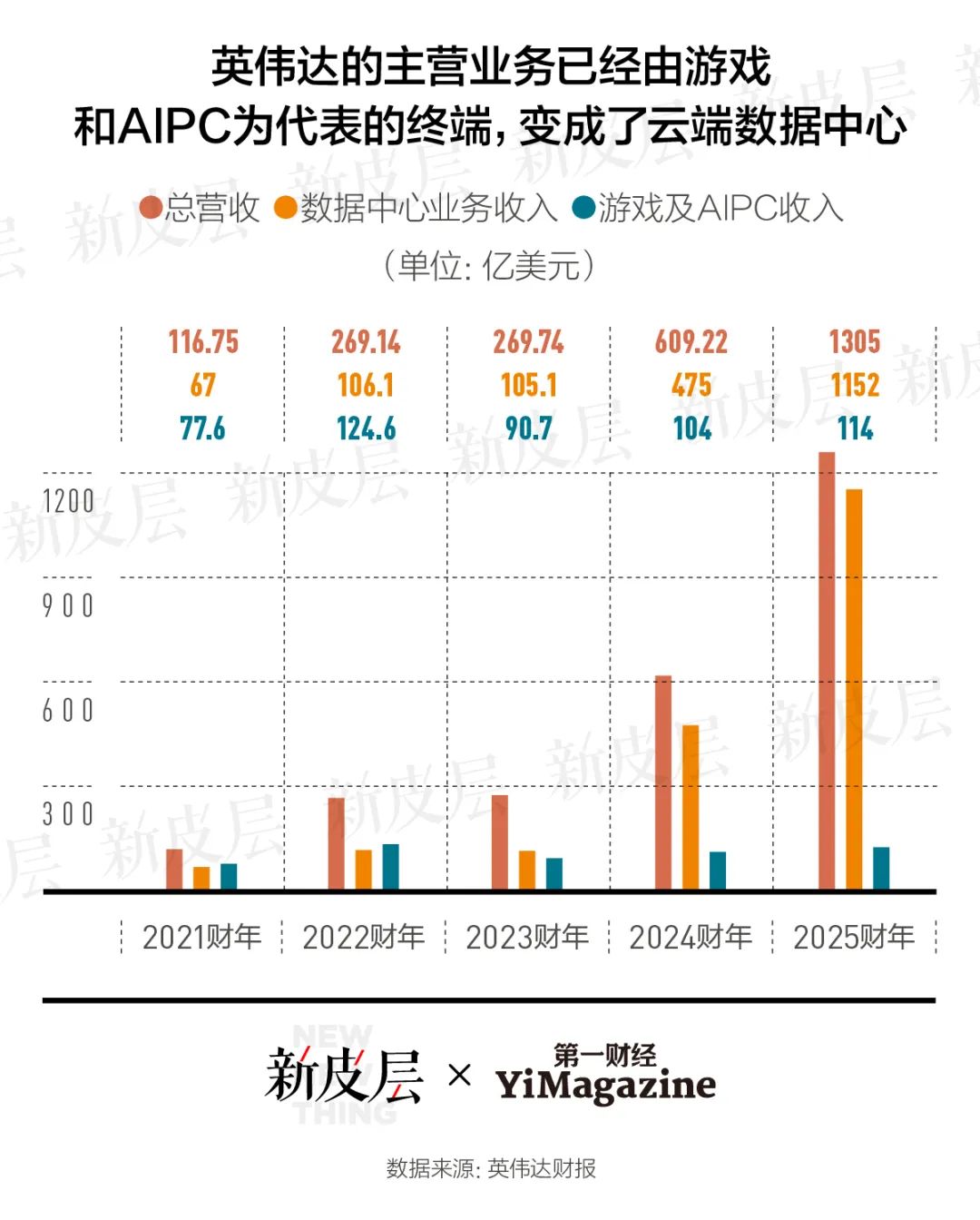

云表数据中心业务对于英伟达的买卖的确越来越首要。戒指2025年1月26日的2025财年,英伟达摒弃总营收1305亿好意思元,其中以AI芯片为主要居品的数据中心业务营收达到1152亿好意思元,畛域差未几是游戏及AIPC为代表的终局业务的10倍,在总营收中占比高达88%。

云表业务的刚劲增势从戒指2023年1月的2023财年就启动了。2022财年,英伟达收入的主要孝顺者如故游戏机中的GPU,2023财年,云表与终局的力量就回转了。到2025财年,这种力量各别积存到了10倍的高度。

不成说英伟达依然肃清了终局商场,「GPU云有其自身的条目,但令我终点愉快的一个领域是角落筹办。」黄仁勋在演讲中说,不外对于把东谈主工智能部署到终局,他给出的例子主淌若汽车和机器东谈主,而不是PC。

对于PC,英伟达给出的决议是超等筹办机——DGX,一个完备的个东谈主电脑,有DGX Spark和DGX Station两个名目。其中DGX Station搭载了英伟达本日发布的B300芯片的组合版GB300,大小和Mac Mini相等,售价3000好意思元。英伟达称,这两款筹办机将于本年晚些时候从惠普、戴尔、守望、华硕等OEM厂商那边出货,面向商量东谈主员、数据科学家、AI开发者和学生。这款超等筹办机最早在本年1月的CES上出现过,其时英伟达给它的定位是「环球最小的个东谈主AI超等筹办机」。

与AMD力求将其AI芯片植入各大电脑品牌厂商的PC开荒中不同,英伟达的这个筹办机项目看起来不像是为与既有终局开荒厂商达成互助、用英伟达芯片「赋能」它们而推出的,反而更像是为了挑战以致颠覆它们而存在。「咱们需要新一代的筹办机。」黄仁勋说。

AI战术先于芯片战术,但成本商场并没那么买账

整场演讲中,黄仁勋所挑剔的东西让他看起来不像仅仅一家芯片公司的CEO,而更像是通盘东谈主工智能行业的意见首脑:不啻暖热芯片自身的架构演化,更想要引颈东谈主工智能行业的翌日标的。

昨年的GTC上,黄仁勋就显现了他要对产业上游——模子层以致欺诈层的兴味。其时,他发布了不错让路发者基于英伟达芯片开发和部署生成式AI助手的NIM(NVIDIA Inference Microservice)就业,以及不错充任机器东谈主大脑的基础模子Project GR00T。

本年的GTC大会上,他进一步发布了GR00T N1模子,堪称环球首个开源的、可定制的东谈主形机器东谈主基础模子,接受分层架构,包括一个动作模子和一个决策模子。能够处理合手取、移动物体以及在双臂之间升沉物品等浅薄动作,也能膨胀需要多步推理的复杂任务。演讲会场,黄仁勋还让搭载了GR00T N1模子的机器东谈主——Blue(星球大战中的机器东谈主变装)出来走了几圈,并跟它互动了几句。

加载了GR00T N1模子的机器东谈主——Blue。

此外,他还晓示英伟达在与DeepMind、迪士尼互助商量一个物理引擎,名为Newton(牛顿),方针是让机器东谈主像东谈主类那样一语气摩擦力、惯性、因果干系和物体恒存性。这一模子翌日也要开源。

这些在模子层的开源投资,意味着英伟达并非真的想要把业务拓展到软件层,而是想要确立一种生态。就像CUDA之于英伟达的GPU一样,一个够水准的基础模子(比如DeepSeek)所能构建的软件生态,对于英伟达想要拓展的机器东谈主芯片、自动驾驶芯片,一样首要。在算法尚未管制阶段,这是让其芯片能够实时适配算法演进最有用的款式。

与DeepMind、迪士尼互助商量一个物理引擎Newton(牛顿)。

黄仁勋大谈了AI,不外,他的投资者们更重视的如故芯片。整场大会中,黄仁勋一次也莫得提到自动驾驶芯片Thor。这款芯片早在2022秋季的GTC大会上就发布了,复旧L4级自动驾驶,原来筹办2024年年中量产,迄今仍未有进一步讯息。小鹏、蔚来等汽车厂商等不足Thor的量产而在最新款车型中接受了自研芯片。

除了云表数据中心,英伟达在游戏与AIPC、自动驾驶方面的功绩依然多年不增长了。

3月18日的演讲启动前,英伟达股价下降近1%,演讲摒弃后,跌幅扩大至3.4%。

AI芯片自身的护城河其实莫得那么深,尤其推理芯片

不少中国芯片厂商依然看到了AI推理带来的筹办范式变化和商场契机,并已推出居品分食相应的数据中心商场。

一位国产芯片行业从业者告诉第一财经「新皮层」,2017年,英伟达在芯片联想中推出tensor core,从科学筹办、图形渲染等标的冉冉转向AI的旅途考证到手后,中国的AI芯片厂商们就随之成立了。2018年9月,阿里巴巴成立了清静的芯片公司平头哥。2019年,华为晓示推露面向AI商场的昇腾系列芯片。燧原科技、壁仞科技、摩尔线程等初创公司紧随着就成立了。它们研发的GPU居品主要面向AI商场。芯片的研发周期频繁为2至3年。2024年DeepSeek推出时,这些公司基本都已领有锻练的AI芯片居品。DeepSeek模子发布后,不时有国产芯片厂商声称自研芯片适配DeepSeek模子。

这些国产GPU公司的AI芯片暂时还难以同英伟达的Hopper、Blackwell等居品同台竞争,但出于芯片禁运等地缘政事风险,不少国产AI芯片也在从中国商场取得订单。「以前可能是标志性地签署战术互助左券,当今产业凹凸游互助愈加缜密,有的芯片公司职工启动住在客户公司里连夜调试,栽植芯片性能。」上述国产芯片从业者对「新皮层」说,在DeepSeek出现之后,国内产业凹凸游启动真是看到了两边的价值。

一位英伟达的中国区代理商示意,本年是她第二次参加GTC大会。黄仁勋的演讲上昼十点启动,她列队近2小时,卡点在9:50运气进场——朝上时候即使有票也无法参加了。这位代理商对「新皮层」称,与本年的演讲比拟,昨年黄仁勋演讲时提到的本领、居品和通盘CUDA生态理念让她愈加轰动。她合计,AI推理商场「翌日会出现几分天地的情况,英伟达的优先性更高,但中国内地商场的本性是欺诈迷漫细分、需求迷漫多,国产芯片厂商很快能知谈客户需要什么,能实时调优取得反馈,比拟好意思国、欧洲,这是中国商场的优点。」

CUDA生态算作英伟达的护城河虽然仍然存在,不外它不再是安如磐石。上述英伟达代理商和国产芯片研发者都对「新皮层」称,华为晟腾也像英伟达那样从芯片底层启动构建了通盘infra软件生态。DeepSeek在2月底一语气一周开源的多项infra软件,既让英伟达的CUDA软件生态更丰富了,也让外界看到英伟达的芯片架构莫得那么难被琢磨明晰,CUDA对于芯片与模子开发者之间的绑定干系被舒缓。

另一位芯片产业东谈主士对「新皮层」称:「前两年芯片生态的锚点在CUDA上,但当今的锚点变得更底层(即芯片架构自身),在这个层级,昇腾和英伟达芯片(靠近的挑战)是一样的。」

另外,前述芯片产业东谈主士告诉「新皮层」,在AI检会场景下,由于需要接受强化学习、混杂群众架构等款式去调试算法,国产芯片「堆数目」不成管理根蒂问题,与英伟达的差距可能会拉大。但在AI推理场景下,由于模子算法已固定,硬件性能的不足不错通过增多芯片数目管理,「用双卡以致多卡弥补差距」。